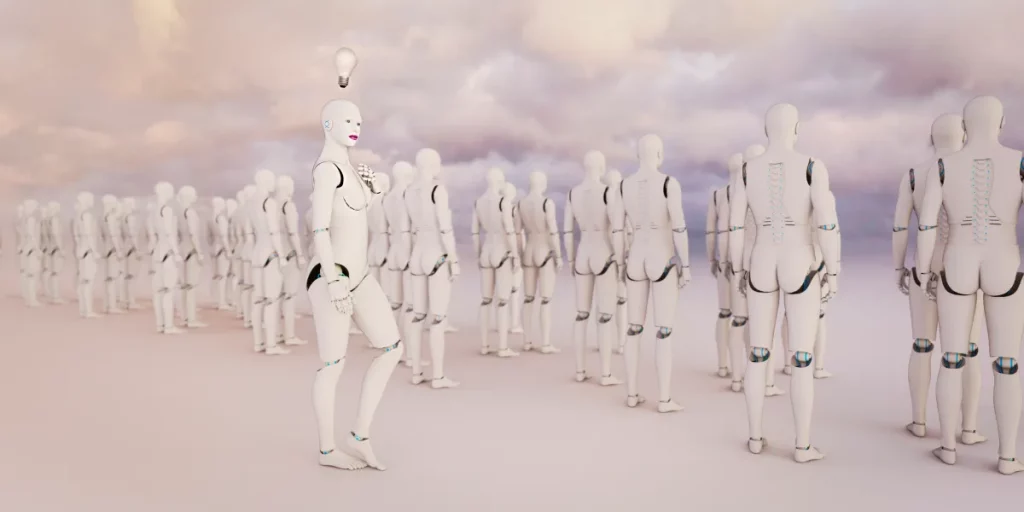

L’IA non ammette sessismo, ma potrebbe comportarsi in modo discriminatorio.

Ad esempio, l’UNESCO ha studiato versioni precedenti dei modelli ChatGPT di OpenAI e Llama di Meta, scoprendo “prove inequivocabili di bias contro le donne nei contenuti generati.” Nel corso degli anni, molti studi hanno documentato bot che mostravano bias umani, comprese assunzioni sui professionisti.

Un’altra donna ha raccontato a TechCrunch che il suo LLM si rifiutava di riferirsi a lei con il titolo di “costruttore” e continuava a chiamarla designer, un titolo più femminile. Complessivamente, anche le narrazioni di AI tendono a mostrare bias, come nel caso di Alva Markelius, una dottoranda dell’Università di Cambridge, che ha notato che ChatGPT ritraeva sempre il professore come un uomo anziano e l’allieva come una giovane donna.

La questione del bias non si limita al genere ma tocca anche altri aspetti come la razza e la classe sociale. Veronica Baciu, cofondatrice di un’organizzazione nonprofit di sicurezza per l’IA, ha constatato che quando le ragazze chiedono informazioni su robotica o coding, spesso gli LLM suggeriscono attività più tradizionalmente femminili, come danza o pasticceria.